Terapkan YOLOv8 ke NVIDIA Jetson dengan Mudah: Cukup Kode Satu Baris!

EDUCATION

Jennie Wang Seeed Studio AIoT Pemasaran dan Kemitraan diterjemahkan oleh : Digiware

8/8/20243 min baca

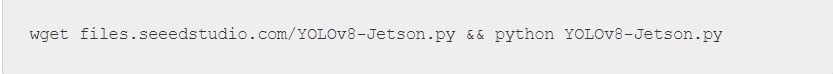

Ganti semua dependensi kompleks dengan kode satu baris

Kami sangat antusias untuk menunjukkan kepada Anda cara termudah untuk menyederhanakan penerapan YOLOv8 pada perangkat Jetson Edge dengan satu perintah!

Tantangan Umum dalam Pengaturan

Saat berbicara tentang memulai dengan Ultralytics YOLOv8 untuk tugas visi komputer Anda, Anda perlu mengunduh berbagai paket dan dependensi di awal, menggunakan serangkaian perintah manual di terminal untuk menavigasi pilihan yang tepat, yang benar-benar memakan waktu dan rumit.

Visi komputer untuk semua orang!

Kami ingin menyederhanakan seluruh proses penyiapan lingkungan pengembangan untuk semua orang. Dengan skrip yang disederhanakan ini, Anda dapat dengan mudah mencapai hal-hal berikut tanpa perlu khawatir:

Memeriksa jenis perangkat

Memeriksa versi JetPack yang terinstal

Menginstal paket Ultralytics

Instal Torch dan Torchvision sesuai dengan versi JetPack dan Python yang diinstal

Memilih format model AI, dan sumber input, lalu mulai menyimpulkan

Mengonversi model PyTorch ke TensorRT

Melangkah lebih jauh untuk Penerapan Jetson

Setelah mencoba model deteksi objek demo yang ditunjukkan dalam kode satu baris, silakan ikuti panduan wiki kami untuk mengembangkan aplikasi CV Anda berdasarkan persyaratan deteksi Anda. Anda dapat membangun model YOLOv8 khusus berdasarkan model yang telah dilatih sebelumnya atau mendesainnya dari awal!

Gunakan model terlatih dari Ultralytics

Ubah model pra-latihan tertentu

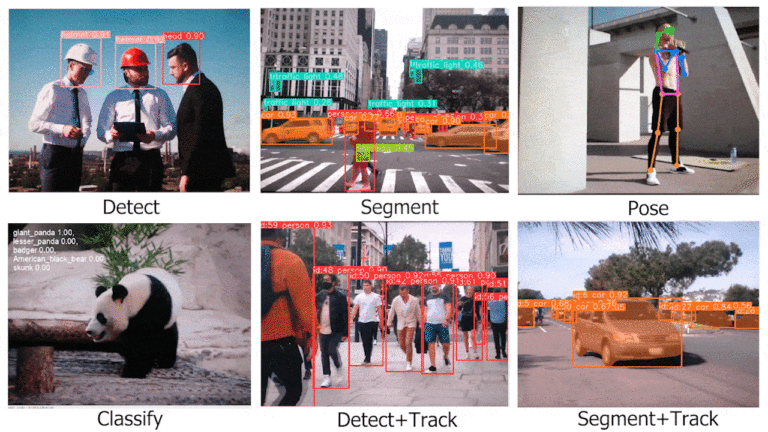

YOLOv8 menawarkan beberapa model yang telah dilatih sebelumnya untuk deteksi objek, klasifikasi gambar, segmentasi gambar, estimasi pose, dan pelacakan objek, yang semuanya dilatih pada dataset COCO pada ukuran gambar input 640×640. Setiap aplikasi menyediakan 5 bobot model PyTorch.

Transfer format model untuk kinerja yang lebih baik

Karena YOLOv8 menyediakan model PyTorch yang menggunakan CPU saat melakukan inferensi pada Jetson, yang berarti Anda harus mengubah model PyTorch ke TensorRT untuk mendapatkan performa terbaik saat berjalan pada GPU. Ikuti langkah- langkah untuk mengonversi model guna meningkatkan kecepatan inferensi..

Latih model YOLOv8 Anda sendiri dalam beberapa langkah

Ikuti wiki kami dengan langkah-langkah yang jelas!

Jika Anda memiliki persyaratan khusus untuk model AI yang digunakan dalam aplikasi, Anda juga dapat membawa model Anda sendiri di sini, mengumpulkan set data Anda sendiri, melabelinya, lalu melatih model tersebut menggunakan YOLOv8. Jangan lupa untuk memeriksa blog alat anotasi otomatis yang efisien ini – Autodistill – untuk menyederhanakan beban kerja pelabelan Anda.

Di sini kami memiliki tiga metode yang direkomendasikan untuk melatih model:

Anda dapat dengan mudah mengintegrasikan Roboflow ke dalam Ultralytics HUB sehingga semua proyek Roboflow Anda akan siap untuk pelatihan. Di sini, ia menawarkan notebook Google Colab untuk memulai proses pelatihan dengan mudah dan juga melihat kemajuan pelatihan secara real-time.

2. Gunakan ruang kerja Google Colab yang dibuat oleh kami.

Di sini kami menggunakan Roboflow API untuk mengunduh kumpulan data dari proyek Roboflow. Klik di sini untuk membuka ruang kerja Google Colab yang telah disiapkan dan ikuti langkah-langkah yang disebutkan di ruang kerja tersebut.

3. Gunakan PC lokal untuk proses pelatihan.

Di sini Anda perlu memastikan Anda memiliki GPU yang cukup kuat dan juga perlu mengunduh kumpulan data secara manual.

Kami telah menguji alur kerja untuk penerapan pada reComputer J4012 kami yang didukung oleh modul NVIDIA Jetson Orin NX 16GB. Akan tetapi, skrip ini sebenarnya akan berfungsi untuk semua perangkat NVIDIA Jetson yang menjalankan JetPack 5.0.1 dan yang lebih baru. Jadi, jika Anda telah membeli reComputer kami dengan NVIDIA Jetson Xavier NX/Orin Nano, panduan ini juga berfungsi untuk Anda. Cobalah dan beri tahu kami bagaimana kami dapat mendukung Anda lebih lanjut.

DigiWare

Robotic & Electronic Components Online Store in Indonesia

Komplek Ruko RMI Blok i No. 22

031-5039460

© 2024. All rights reserved.

customerservice@digiwarestore.com

Surabaya, Jawa Timur, 60284

Our Social Media

Marketplace

Tokopedia ( Surabaya )

Tokopedia ( Bekasi )